随着人工智能大模型参数规模持续膨胀,全球算力基础设施正经历一场以互联架构升级为核心的变革。据行业分析,2026年将成为关键转折点,商用GPU出货量与云服务商自研ASIC芯片部署规模同步攀升,推动数据中心内部通信方式发生根本性转变。这场变革中,光通信与铜缆技术形成互补格局,共同支撑起超大规模算力集群的运转需求。

英伟达最新发布的Rubin架构为行业树立了技术标杆。其NVL 144机柜通过第六代NVLink与NVSwitch技术,实现单柜129.6TB/s的双向带宽。在物理连接层面,该架构采用1.6T规格的AEC铜缆完成GPU与交换芯片的高密度互联,单通道速率提升至224G。这种设计使铜缆在机柜内部短距传输中占据主导地位,同时通过胖树拓扑结构解决超大规模集群的网络拥塞问题。测算显示,构建9216张GPU集群需要288台脊交换机,光模块与芯片配比达到1:12,直接拉动高端光模块市场需求。

谷歌TPU集群的互联方案展现出独特的定制化特征。其64卡机柜采用3D Torus拓扑结构,通过混合连接方式实现4.8TB/s的双向互联速率。柜内网络中,80根铜缆承担非相邻板卡间的直接通信任务,而光模块则负责机柜外部连接。在超大规模集群部署中,谷歌引入光路交换技术(OCS),通过64台300x300端口设备动态调整光路连接,使十万卡级别训练任务的功耗降低30%以上,同时提升网络配置灵活性。

亚马逊Trainium3芯片的组网方案突出物理层创新。NVL72*2配置中,144颗芯片通过PCB印制电路板、背板连接器及AEC铜缆实现三层级联,单机柜内部部署216根64端口PCIe铜缆。这种全铜互联方案在保证400G低延迟带宽的同时,使机柜功耗降低25%。在集群扩展方面,亚马逊采用双平面网络架构,ENA网络处理前端流量,EFA网络专注算力通信,通过Clos拓扑结构支持线性扩展至13万张芯片规模。

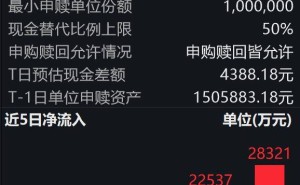

meta的解耦架构(DSF)为行业提供新思路。Minerva机柜采用Tomahawk5交换芯片与112G PAM4铜缆背板组合,实现204.8Tbps对称带宽。在超大规模集群部署中,DSF两级交换网络通过1:1带宽收敛比确保无阻塞传输,构建18432颗芯片集群需要消耗18.4万个800G光模块。这种设计凸显光模块在长距互联中的不可替代性,同时证明铜缆技术在短距场景仍具成本优势。

行业分析指出,2026年AI算力建设将呈现"光铜共进"特征。在机柜内部,DAC、AEC等高速铜缆凭借低功耗、低成本优势成为主流选择,带动相关产业链产能扩张。而在节点间通信领域,随着集群规模突破十万卡门槛,光模块需求将呈指数级增长。特别是英伟达、meta等企业的高配方案中,光芯片与光模块配比显著提升,可能引发新一轮产能竞争。建议关注光通信芯片与高速铜缆连接器领域的头部企业,这些公司在技术迭代与产能布局方面已占据先发优势。