当MapReduce在2008年写下第一行分布式计算代码时,或许没人能预见到这场技术革命将如何重塑人类与数据的关系。从TB级日志处理到毫秒级实时决策,十五年间大数据技术完成了从“管道系统”到“神经系统”的蜕变。这场演进不是线性进步,而是技术栈在碎片化、实时化、治理化、平台化、智能体化等多重压力下的结构性重构。

2010年前后,Hadoop体系以“平民化”姿态打破数据仓库的贵族垄断。HDFS支撑TB级数据存储,MapReduce通过分而治之的计算模型,让中小企业能用x86服务器集群处理上百GB数据。Hive将SQL转化为MapReduce任务,Pig提供脚本化编排,这些工具共同构建起批处理时代的基石。但稳定性压倒灵活性的架构设计,使得数据工程师需要专职应对任务调度失败,数据从进入到产出结果往往以小时甚至天为单位计算。这种“能算就行”的模式,在业务对分钟级反馈的需求面前迅速显露出局限性。

2014年Spark的崛起标志着内存计算时代的到来。通过将数据加载进内存,处理延迟从小时级压缩到分钟级;DAG调度机制以有向无环图动态规划任务路径,避免中间落盘。Spark SQL的出现更让非技术人员能直接查询海量数据,推动“数据民主化”初现端倪。但真正的转折发生在2017年,Flink凭借原生流批一体架构和Exactly Once语义,成为金融风控等高一致性场景的黄金标准。Kafka作为数据动脉连接各环节,与Flink、Presto共同构建起实时计算新范式。然而工具堆叠带来的接口割裂、权限混乱、链路丢失等问题,让企业陷入“工具越多效率越低”的悖论。

2020年后,Lakehouse架构的出现解决了数据湖“存得下但用不来”的困境。通过整合数据仓库的结构化管理优势与数据湖的存储能力,Iceberg和Delta Lake技术支持增量读取、ACID事务,让数据既能高效存储又能实时计算。元数据管理从简单的权限管控升级为数据血缘追踪,DataOps理念将数据质量管理、可用性保障、合规性监控纳入全生命周期管理。这种架构融合使企业能通过标准SQL接口直接访问数据,不再受困于数据沼泽。

“数据飞轮”理念在2023年前后成为主流战略框架。智能调度系统让数据在不同平台间自动流转,业务反馈持续修正分析模型,机器学习模型与实时数据流结合实现自动化决策。这种跨工具、跨部门、跨生态的系统化协作,使数据在生产、运营、决策等环节形成完整闭环。但真正的革命性突破发生在2025年前后,Data Agent概念将数据处理从被动分析转向主动执行。通过融合AI大模型技术,这些智能体能根据实时数据流自动选择处理方法,触发价格调整、库存优化、广告投放等业务决策。

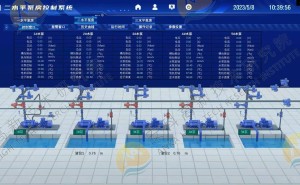

DataOS的崛起标志着数据管理进入操作系统时代。这个“数据中枢”不仅调度存储计算资源,更通过智能引擎确保各平台协同工作。当数据采集存储、实时处理分析、自动决策反馈形成毫秒级闭环时,人类首次获得了“即时理解世界”的能力。广告推荐系统每秒处理数百万次点击,金融交易平台在微秒间完成风险评估,工业预警系统实时捕捉设备异常——这些场景背后,是无数个“观察-判断-反应”的智能循环。

但技术跃进的代价是系统复杂性的指数级增长。抽象层的叠加、组件的耦合、协同能力的依赖,构成了新的挑战。当数据处理速度突破毫秒级阈值,人类反而难以完整理解自己构建的系统。这种悖论揭示着大数据技术的本质:我们创造了前所未有的感知网络,却仍在探索如何让智能真正服务于人。在速度不会放缓的未来,学会在更快系统中做出稳健决策,将成为新的生存法则。